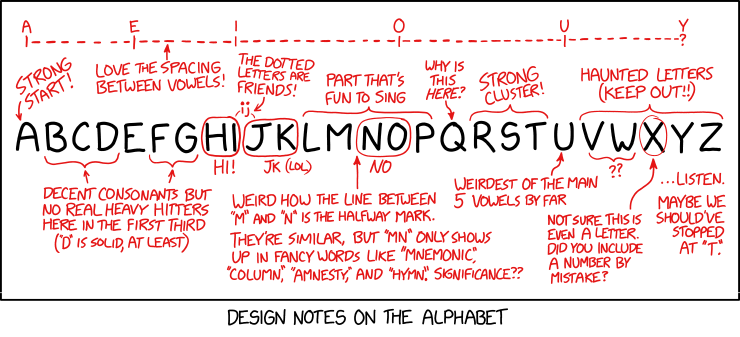

Title Text:We’ve learned that weird spacing and diacritics in the methodology description are apparently the key to good research; luckily, we’ve developed an AI tool to help us figure out where to add them.

Origin:https://xkcd.com/2451/

https://www.explainxkcd.com/wiki/index.php/2451:_AI_Methodology

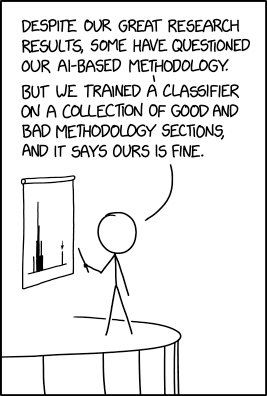

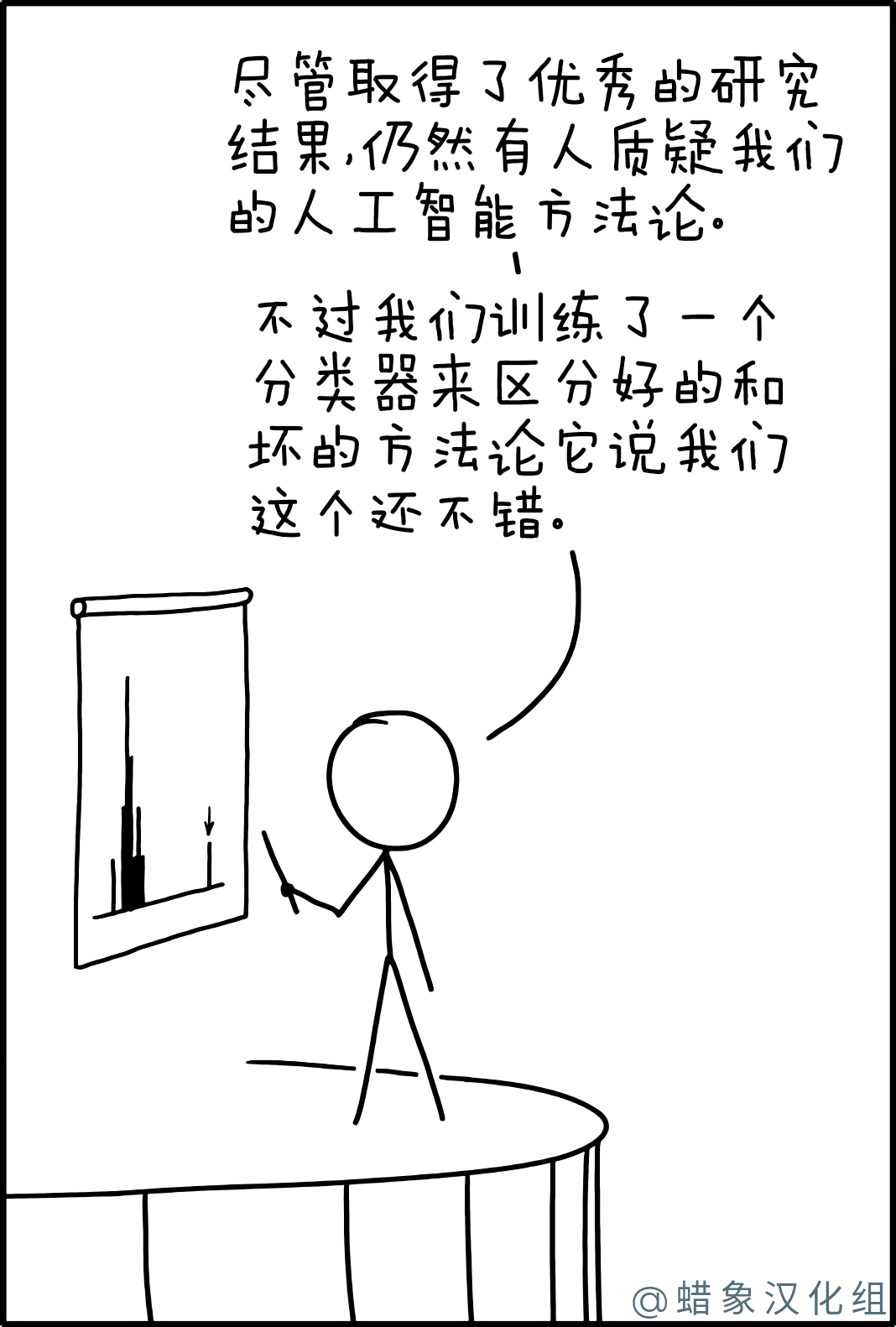

人工智能方法论

http://xkcd.in/comic?lg=cn&id=2451

这部漫画中的一个笑话是,人们在使用人工智能(AI)时却不了解该如何做,因此,有关的研究充其量是不可靠的,甚至可能是有意破坏的。研究人员承认他们的方法存在风险,需要额外的验证,但针对这些问题反复使用同等或更不可靠的基于AI的解决方案。因此,他们的问题可能和以往一样严重,并且任何其他使用他们的验证工具之一的团队也可能会遇到类似的不可靠性。有关机器学习的介绍,您可以访问https://fast.ai/。

原始研究[编辑]

第一条评论“有些人质疑我们基于AI的方法论”,指的是难以验证基于AI的处理的正确性。当模型(测试程序无法解决基于AI的统计分析问题)在未经过充分测试时可能显得可靠。由于训练数据的持续影响或降低调查质量的不良算法,模型容易出现问题。因此,使用此类模型进行研究必须证明这些模型已经过充分测试,以至于其结果可能有用。通常,在训练后会执行其他测试,以确认模型可以处理与训练数据不同的方式收集的数据。

方法学质量分类器[编辑]

Cueball试图通过量化他的方法论的质量来使听众放心。他通过创建另一个AI来对方法进行排名来做到这一点。由于多种原因,这种方法不太可能灌输信心:

- 质量AI和原始研究AI由同一团队编写。如果最初的研究AI设计不当,那么质量AI可能会与它共享设计问题。

- 创建的特定类型的模型不太可能是正确的模型。Cueball将此称为分类器,它通常是一种模型,可将输入分配为不同的互斥类别。例如,假定该文本块仅使用一种语言,则可以使用分类器来确定该文本文本块是什么语言。但是,质量是数据的一个连续方面。方法学的分类器可能会将其分类为“不良”,“中等”和“良好”类别,而有效的模型应具有给出更精确等级的能力。选择分类器可能表明Cueball不知道要使用哪种类型的模型。

- 没有提到这种高质量的AI的训练数据。例如,如果将团队先前的研究用作良好方法论的例子,则AI可能也会从他们那里判断所有方法论。

- 一个方法,部分是指写作的质量,是研究论文的特定部分。一个好的方法论部分将准确,清楚地解释他的所作所为,但这并不意味着研究方法论本身是有效的。Cueball并未表明他是否相信自己的模型正在尝试分析所述方法的质量,但是在任何情况下,这对于现有的机器学习来说几乎都是不可能的。

- 试图判断方法论部分的AI收到了大量难以处理的输入。它必须使用自然语言处理来理解方法论部分中的写作,并且还需要大量有关主题的专业知识才能判断质量。这将需要尚未实现的人工智能(AGI)。由于AI无法完全理解复杂的研究,因此AI可能会使用不重要的细节来判断方法。

- 排名最高的AI强烈支持Cueball的AI的方法论,并且可能会有偏差。它显示了一个正态分布,在最右边有一个奇异的异常,上面有一个箭头。可以从箭头推断出该数据点代表了AI的方法论。这是一个很大的异常值,因此,它可能无法准确表示Cueball的AI。或者,这可以被视为AI的“裙带关系”,在这种情况下,Cueball的方法学AI更有可能选择基于AI的方法。2237:AI招聘算法中提到了这种类型的算法偏差。

间距AI(来自标题文本)[编辑]

尽管原始AI和质量AI中存在许多危险信号,但从理论上讲,它们可能像Cueball所说的那样运作。标题文本中有关间距和变音符号的注释证明事实并非如此,并且至少质量AI完全被破坏了。通过各种复杂的方式为AI模型提供输入,并根据统计分析确定哪些细节很重要。这样的模型可以轻松地在训练数据中找到与正确答案相关的细节,但会使生成的模型无用。

例如,一个研究小组曾经创建了一个模型,该模型将获得医学信息,以确定患者患癌症的可能性。该模型已经过现有患者记录的培训,团队计划将其用于新患者。但是,原始模型没有使用医疗信息,而是简单地检查了医院的名称-医院名称中带有“癌症中心”的患者很可能患有癌症。该模型已经确定了与所需答案相关的数据点,但是这种相关性对于预期目的没有用。有关模型被丢弃,没有医院名称的新模型被创建。

在这种情况下,方法论部分是由人类编写的文本,其中可能包含书写过程中的各种工件。这些可以包括详细信息,例如用户如何选择插入空格,单词用法,拼写或变音符号,这些在英语中是可选的(例如,幼稚还是幼稚)。看来训练信息识别出与“良好”方法有关的某些模式。这表明该研究团队还有其他一些问题:

- 他们的AI使用毫无意义的细节来决定方法论部分的质量,因此这是没有用的。

- 他们还没有意识到它是无用的,因此他们的其他AI可能存在致命缺陷。

- 间距信息与良好的方法学密切相关,这意味着它们可能没有太多不同的训练数据源。他们的样本量太小,即使对AI进行了改进以忽略此信息,它也需要更多数据才能有用。