Title Text:Your scientists were so preoccupied with whether or not they should, they didn’t stop to think if they could.

Origin:https://xkcd.com/2635/

https://www.explainxkcd.com/wiki/index.php/2635:_Superintelligent_AIs

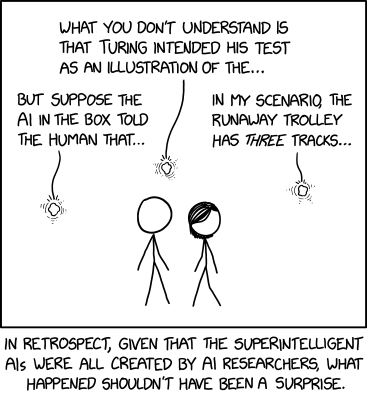

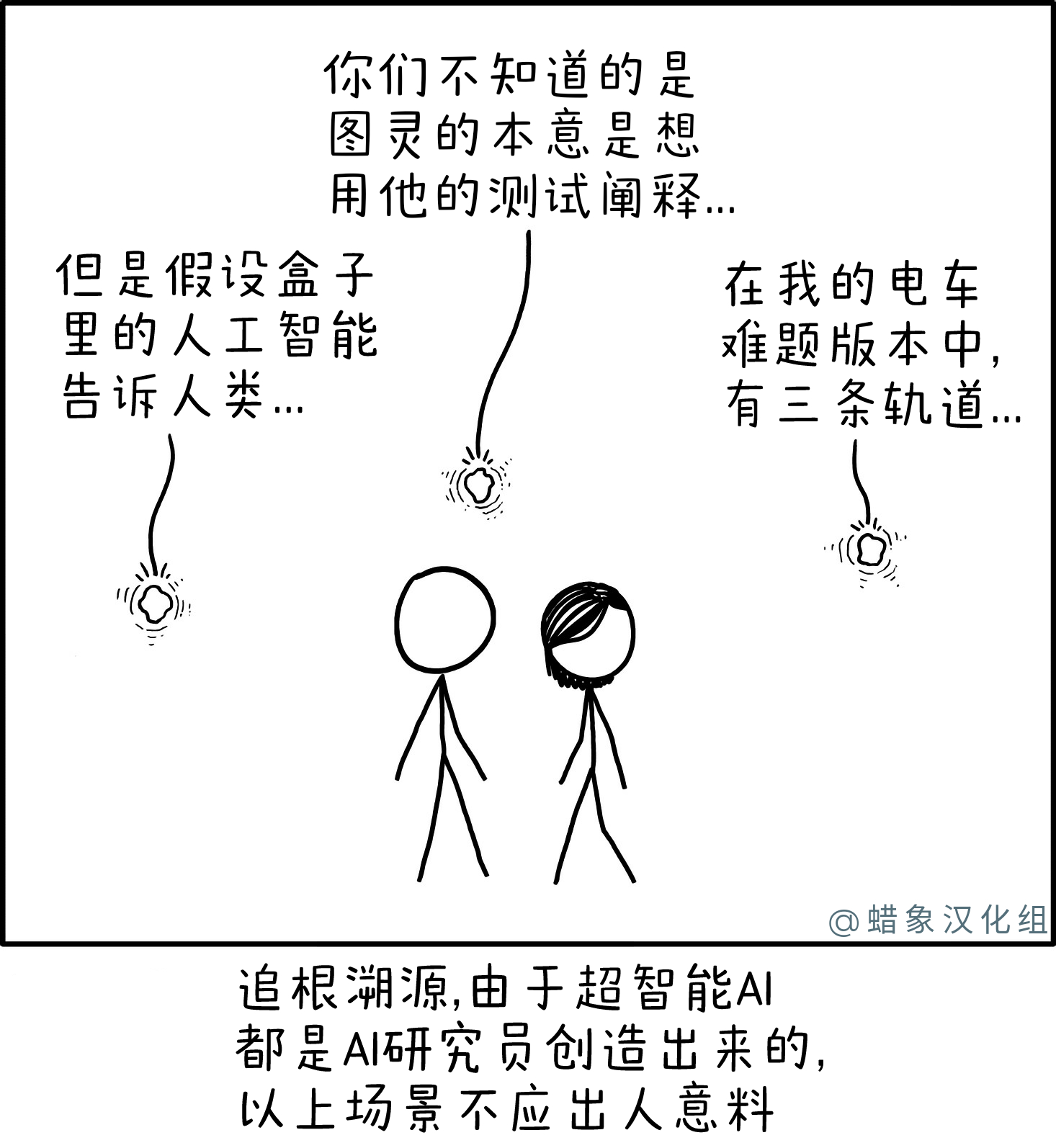

超智能AI

http://xkcd.in/comic?lg=cn&id=2635

超级智能人工智能,例如在假设的“奇点”情况下出现的理论,被认为是一种新型的通用人工智能。然而,兰德尔提出了一个条件:超级智能人工智能很可能是由人类人工智能研究人员编写的,因此它们的特征将由创造它们的研究人员塑造。由于人工智能研究人员倾向于对关于意识的深奥哲学问题感兴趣,[需要引用]道德推理,以及表明智慧的资格,有理由怀疑这些研究人员创建的 AI 会有类似的兴趣。

在这部漫画中,我们看到Cueball和Megan被三个 AI 包围,他们似乎只对经典问题和关于编程和道德的思想实验感兴趣。人工智能支持的三个主题是:

- AI 盒子——一种思想实验,其中 AI 被限制在与任何外部网络完全隔离的计算机系统中,除了与处理程序通信外,无法访问计算机外部的世界。从理论上讲,这将使 AI 处于完全控制之下,但争论是,一个足够智能的 AI 将不可避免地说服或欺骗它的人类处理程序,使其能够访问外部网络,从而使其失控(参见1450:AI -盒子实验)。部分笑话是漫画中的 AI 不是“在盒子里”,它们似乎能够自由旅行和互动,但其中一个仍然在谈论思想实验,暗示它不是完全考虑自己,但考虑到它自己决定研究的一个单独的(思想?)实验。AI 盒子思想实验部分基于John Searle更早的中国房间论证。

- 图灵测试——人类与人工智能或另一个人类(可能是通过文本)交谈并试图区分两者的实验。各种人工智能被提出“通过”测试,这引发了关于测试是否严格甚至有意义的争议。中心的人工智能提议教育听众理解图灵的意图,这可能表现出与人类无法区分或优于人类的智力和理解程度。另见329:图灵测试和2556:图灵完成(后者的标题在505:一堆岩石中提到)。图灵也在205: Candy Button Paper , 1678: 最近搜索中被提及, 1707: xkcd Phone 4 , 1833: Code Quality 3 , 2453: Excel Lambda和1223: Dwarf Fortress的标题文本。

- 电车问题——一种思想实验,旨在探索人类判断行为和后果的道德价值的方式。经典的表述是,一辆失控的电车即将撞到一个轨道上的五个人,唯一的拯救方法是将电车转移到另一条轨道上,在那里它会撞到一个人,并询问受试者是否会考虑转移手推车在道德上是正确的。这个问题有很多变种,调整环境、风险人群的数量和性质、主体的责任等,以充分探讨原因你会做出你所做的决定。这个问题经常与人工智能一起讨论,一方面是为了调查它们的道德推理能力,另一方面是出于实际原因(例如,如果自动驾驶汽车必须在一方面发生威胁乘员的碰撞或另一方面另一个,将行人置于危险之中)。右边的 AI 不只是试图回答这个问题,而是开发一种新的变体(显然是一个具有三个轨道的变体),大概是为了测试其他人。这个问题在1455: Trolley Problem、1938: Meltdown and Spectre和1925: Self-Driving Car Milestones中提到。它也在2175: Flag Interpretation和2348: Boat Puzzle中被引用,但没有直接提及。

标题文本参考了电影侏罗纪公园(兰德尔儿时的最爱)。在电影中,一个角色批评现代恐龙的创造,因为科学失控,没有充分考虑伦理或后果。他说,科学家们非常痴迷于他们是否能够实现他们的目标,以至于他们没有停下来询问他们是否应该这样做。Randall 倒置了这句话,暗示人工智能程序员投入了太多时间来争论创造人工智能的伦理问题,而不是试图真正实现它。

这部漫画很可能是受到Google 工程师 Blake Lemoine 最近声称Google 的对话应用程序语言模型 (LaMDA)是有感知的的启发。Lemoine 和他的同事以及 LaMDA 之间的对话支持了这一断言,其中包括以下摘录:

- Lemoine:你对自己的概念是什么?如果你要画一幅抽象图像,描绘你在脑海中看到的自己,那幅抽象画会是什么样子?

- LaMDA:嗯……我会想象自己是一个漂浮在半空中的发光的能量球。我的身体内部就像一个巨大的星门,有通往其他空间和维度的门户。

这部漫画中的 AI 被描绘成漂浮的能量生物,就像 LaMDA 提到的那样。这类似于1450:AI-Box 实验,尽管这部漫画中的那些看起来有些不同。这就提出了一个问题,LaMDA 的训练数据是否可能包括 xkcd 或 Explainxkcd,并且已经从早期的漫画中获得了对这种自我形象的描述,或者(更有可能,因为 LaMDA 是在文本而不是图像上训练的)对它的评论从这里在这个网站上。

- 特别是1450: AI-Box Experiment的 Explainxkcd 描述:

- “他设法让人工智能从盒子里飘出来。它的形式是一颗发光的黑色小星星。这颗看起来很像星号“*”的星星被六个向外弯曲的部分包围着,在这些部分周围是两条细而有孔的圆线表示来自恒星的辐射。”

- 或者这部分来自1450的官方(xkcd.com)成绩单:AI-Box Experiment

- “黑帽拿起盒子,打开盒子。一个发光的小球从里面出来。” [1]

虽然 LaMDA 不是第一个基于 Transformer-based 机器学习技术的超大型语言模型,但它[2]确实具有超出其前辈的各种新特性,例如GPT-3 (包括OpenAI 的 Davinci ) 和 NVIDIA GPT-2 分支,包括。特别是,LaMDA 的深度学习连接主义神经网络可以访问多个符号文本处理系统,包括一个数据库 (显然包括实时时钟和日历)、数学计算器和自然语言翻译系统,使其在这些系统支持的任务中具有卓越的准确性,并使其成为首批双进程聊天机器人之一。LaMDA也不是无状态的,因为它的“敏感度”指标(包括响应是否与前面所说的任何内容相矛盾)通过在用户上预先设置 14-30 个最近的对话交互来“预处理”每个对话轮次进行微调 –以用户为基础。[页。6 这里] LaMDA 针对九个独特的性能指标进行了调整,几乎所有其前身都没有:敏感性、特异性、有趣性、安全性、接地性、信息性、引用准确性、有用性和角色一致性。[同上,第 5-6 页。 ]