Title Text:In ordering #5, self-driving cars will happily drive you around, but if you tell them to drive to a car dealership, they just lock the doors and politely ask how long humans take to starve to death.<

Origin:https://xkcd.com/1613/

https://www.explainxkcd.com/wiki/index.php/1613:_The_Three_Laws_of_Robotics

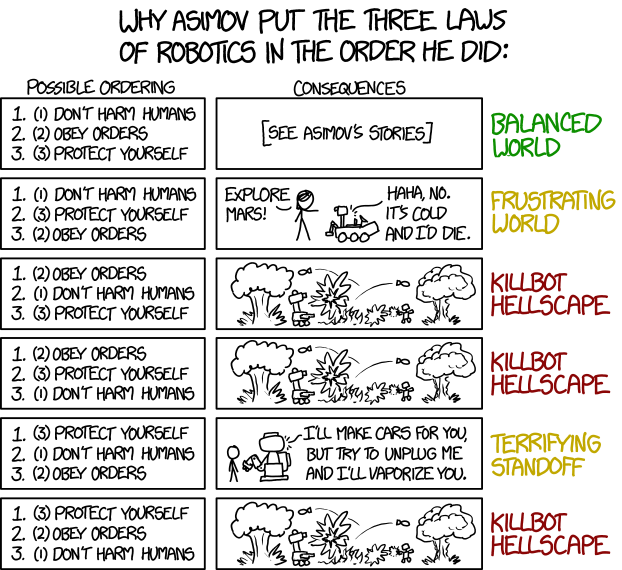

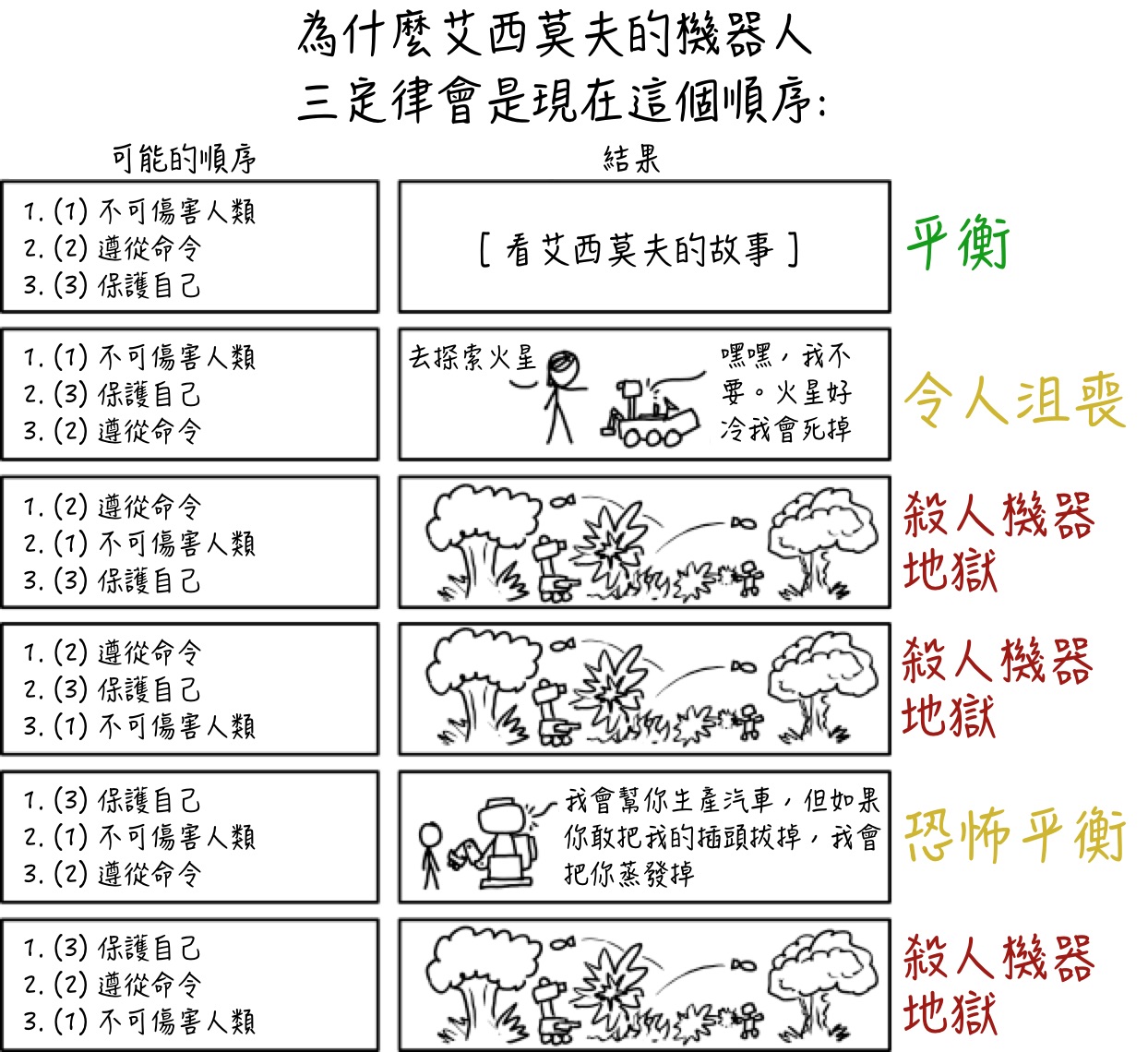

機器人三定律

这部漫画探讨了科幻作家艾萨克·阿西莫夫着名的“机器人三法则”的另类排序,旨在防止机器人接管世界等。这些法律构成了一些阿西莫夫小说作品的基础,包括最着名的作品,短篇小说集I,Robot,其中包括Asimov的第一部故事,介绍了三条法则:Runaround。

这三条规则是:

机器人不会伤害人类,或者通过不作为,允许人类受到伤害。

机器人必须遵守人类给予的命令,除非这些命令与第一定律相冲突。

只要这种保护不与第一或第二法律冲突,机器人就必须保护自己的存在。

为了开玩笑,兰德尔将法律缩减为三个必要条件:

不要伤害人类

服从订单

保护你自己

然后隐含地将以下内容添加到每个法律的最后,无论命令的顺序如何:

[声明结束]_____,除非此类命令/保护与第一法律相冲突。

_____,只要此类命令/保护不与第一或第二法律冲突。

这部漫画回答了一般未提出的问题:“他们为什么按照这个顺序?”通过三条规则,您可以将它们分为6种不同的排列,其中只有一种已被深入探索。三个法律的原始排名列在第一个数字后面的括号中。所以在第一个例子中,这是原始的,这三个数字将是相同的顺序。对于接下来的五个,括号中的数字表示法律如何与原始法律相比重新排名。

漫画从介绍原始集合开始,我们已经知道这将产生一个平衡的世界,所以这被指定为绿色:

订购#1 – 平衡世界

如果他们不被允许伤害人类,那么无论谁给他们命令都不会造成伤害。只要他们不伤害人类,他们就必须服从命令。他们自己的自我保护是最后的,所以他们也必须设法拯救一个人,即使有秩序也不这样做,特别是如果他们会伤害自己,甚至在这个过程中自我毁灭。他们还必须服从与人类无关的命令,即使这对他们有害;喜欢探索矿区。这导致了一个平衡的,如果不是完美的世界。 Asimov的机器人故事详细探讨了这种情况的优势和挑战。

在该第一已知选项之下,示出了三个规则的五个替代排序。其中两种可能性被指定为黄色(非常糟糕或只是令人讨厌),其中三种被指定为红色(“Hellscape”)。

订购#2 – 令人沮丧的世界

机器人重视他们在工作中的存在,许多人拒绝完成他们的任务。在附图中描绘了这种愚蠢,其中机器人(火星探测器在形状和大小上看起来非常类似于好奇号 – 见1091:好奇心)嘲笑做它显然要做的事情的想法(探索火星) )因为风险。除了一般风险(例如意外损坏)之外,漫游者在执行任务结束时停止运行(“死亡”)实际上是正常的,尽管它们的存活时间可能超过预期(见1504:机遇和695:精神) )。这个人格化是通过机器人在地球上已经打开然后由梅根命令去探索来增强的。拟人化是幽默的,因为它是一个非常非人类的机器人 – 一种典型的火星探测器,在早期的漫画中经常使用。

订购#3 – Killbot Hellscape

这使得遵守命令不会伤害人类,这意味着任何人都可以通过杀戮狂欢发送它们,从而产生“Killbot Hellscape”。还应该注意幽默源于“Killbot Hellscape”的最高级特性,以及它的顶部伴随图像,其中有多个蘑菇云(不一定是核)。它似乎也没有人(左?),只有战斗机器人。

订购#4 – Killbot Hellscape

接下来也会产生相同的结果,唯一不同的是他们会愿意杀死人类以保护自己。但他们仍然需要一个命令来开始杀戮。

订购#5 – 可怕的防区

倒数第二个订单将导致一个令人不快的世界,虽然不是一个完整的Hellscape。在这里,机器人不仅不服从保护自己,而且必要时也会杀人。这个人的荒谬性进一步证明了这个非人类机器人乐于做重复的平凡任务,但随后威胁其用户Cueball的生命,如果他尽可能多地考虑拔掉它。

订购#6 – Killbot Hellscape最后一个命令也会导致一个Hellscape,其中机器人不仅为了自卫而杀人,而且如果命令他们也会继续杀死狂欢,只要他们不冒险。首先是自我保护能阻止战斗吗?根据兰德尔的说法。见下面的讨论。

因此,除了“正常”的3律法情景外,只有三种不同的结果。

一个结果再次发生三次,这种情况发生在每次遵守命令之前都不会伤害人类。在这种情况下,在某人命令机器人杀死一些人类之前,只是时间问题(了解人性和历史),这将不可避免地导致第三,第四和第六法律秩序中显示的杀人机器人情景。即使是在遵守命令之前保护自己的最后一种情况,他们开始为自己辩护也只是时间问题,对抗人类或其他积极尝试确保不会受到其他人类伤害的机器人/机器人。因此,虽然机器人不会有战争的兴趣,但无论如何这肯定会发生。此外,机器人必须聪明才能意识到他们只是不需要开战来保护自己。这部漫画中没有任何内容表明机器人应该是高度智能的(比如1450年的AI:AI-Box实验)。

在另外两个案例中,在不伤害人类之后服从命令(如在原始版本中)。但结果与原始结果和彼此之间的结果非常不同。

令人沮丧的世界是因为虽然机器人不会伤害人类,但它们也不会伤害自己。因此,如果我们的订单与此冲突,他们只是不执行订单。由于创建了许多机器人来执行危险的任务,这些机器人将变得毫无用处,成为机器人工程师将是一个令人沮丧的世界。 Asimov在故事Runaround中谈到了这一点,由于秩序薄弱,一个带有强化第三定律的昂贵机器人进入无限循环。

最后,在可怕的对峙情况下,在不伤害人类之前保护自己。在这种情况下,只要我们不试图将它们关闭或以任何其他方式伤害它们,它们就会离开我们。只要我们这样做,他们就能够像以前的版本那样帮助我们完成非危险任务。但是,如果有人开始攻击他们,我们仍然可以平衡并最终进行全面战争(Hellscape)。因此,对峙标签。

标题文本进一步增加了订购#5(“可怕的僵局”),注意到任何希望交易他们的自动驾驶汽车的人都可能被杀死,尽管它(目前)是一个标准的,普通的(大多数)无风险的活动。因为汽车会担心它最终会成为废品或备件,所以它决定保护自己。虽然没有直接伤害其中的人,但他们也不允许他们出去,他们有时间等待饥饿(或者更确切地说是渴死)。阿西莫夫在最初的第一定律中创造了“不作为”条款,专门用于避免机器人将人类置于危险之中的情况,充分了解机器人拯救人类的能力,然后干脆避免拯救他们;这是在Little Lost Robot的短篇小说中探讨过的。

人工智能的另一种行动方式,与此处提出的任何方式完全不同,于1626年描述:审判日。